导语 英伟达 AI 团队近日再度突破界限,推出开放视觉行动基础模型 NitroGen。该模型通过学习 40,000 小时的海量视频数据,无需代码介入即可掌握游戏操控逻辑,为通用游戏智能体的构建提供了全新的技术范式。

视频即数据 重新定义游戏AI训练逻辑

传统游戏 AI 的训练往往依赖于对游戏内部接口的深度挖掘或定制化开发,而 NitroGen 走了一条更为通用的 "人类视角" 路线。该模型的核心构建始于对公开游戏视频的深度挖掘。

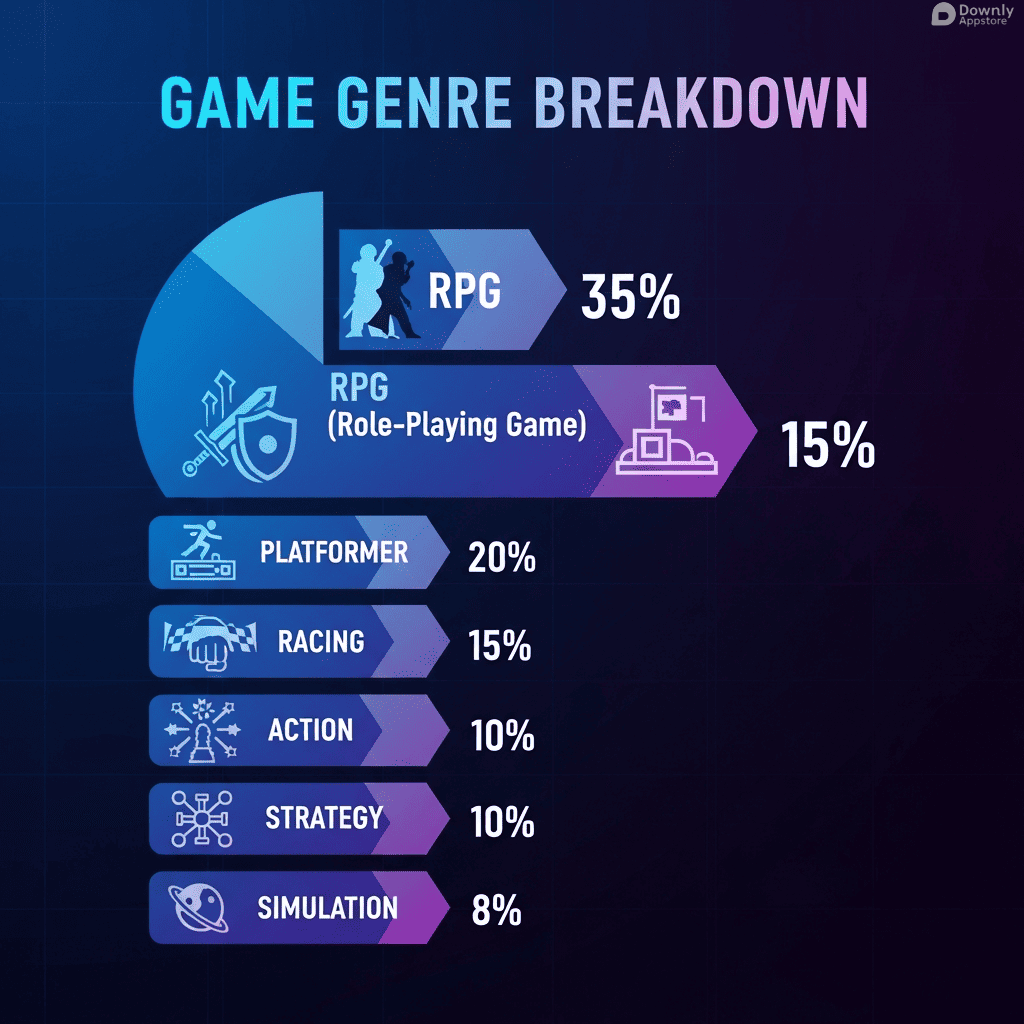

研究团队构建了一个庞大的数据管道,收集了总计 71,000 小时的原始视频素材。经过严格的质量过滤,最终提炼出 40,000 小时的精选数据。这些数据涵盖了 818 位创作者上传的 38,739 个视频,跨越了 846 款截然不同的游戏。数据分布显示,动作角色扮演类游戏(ARPG)占据主导地位,占比达 34.9%,其次是平台跳跃类(18.4%)和动作冒险类(9.2%)。这种多样化的数据构成,为模型理解复杂的 3D 空间关系和操作逻辑奠定了基础。

三阶段提取 并不是简单的模仿

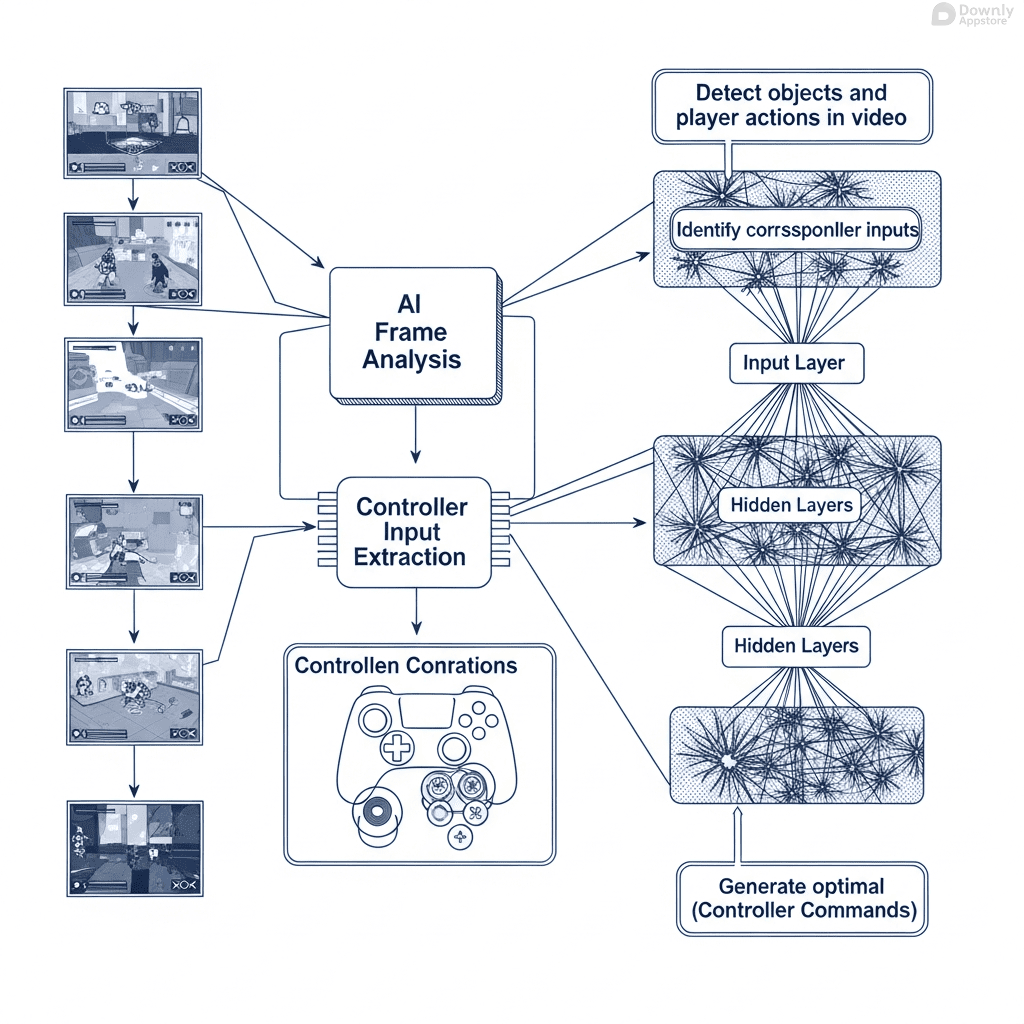

NitroGen 并非简单地 "看" 视频,而是通过一套精密的三阶段提取流程来 "理解" 操作。

首先,系统利用 300 个标准化的控制器模板,在视频画面中精准定位游戏手柄的 UI 叠加层。随后,基于 SegFormer 的分类分割模型会对这一区域进行深度解析,将视觉信号转化为具体的按键指令。最后,通过坐标精细化处理,确保动作预测的毫秒级准确性。这一流程让 NitroGen 具备了大规模行为克隆的能力,使其能够像人类玩家一样,仅凭画面反馈做出决策。

此外,随模型发布的还有一个通用模拟器。它能将商业 Windows 游戏无缝封装为兼容 Gymnasium 的接口,实现逐帧互动而无需修改任何底层代码,极大地降低了跨游戏策略迁移的门槛。

扩散架构驱动 性能与迁移能力的双重飞跃

在架构层面,NitroGen 采用了基于 Diffusion Transformer 的先进策略,专门针对 256×256 分辨率的 RGB 图像进行优化。这种架构选择使得模型在生成动作策略时具备了极高的鲁棒性。

实测数据显示,NitroGen 在多个零样本(Zero-shot)评估任务中表现优异,任务完成率稳定在 45% 至 60% 之间。更令人瞩目的是其迁移学习能力:当应用于一款从未见过的全新游戏时,经过预训练的 NitroGen 相较于从头开始训练的模型,性能提升幅度高达 52%。这证明了该模型不仅记忆了操作,更习得了通用的游戏交互逻辑。

相关推荐

2025 AI 技术峰会

AI 实战课程

热门工具

AI 助手

智能对话,提升效率

智能图像处理

一键美化,智能修图

AI 翻译

多语言实时翻译

评论 (0)

暂无评论,快来发表第一条评论吧!