导语:Meta 推出全球首个统一多模态音频分离模型 SAM Audio,支持通过文本、点击画面物体或标记时间段来精准提取特定声音,并同步开源了相关评测工具。

听觉与视觉的深度融合

Meta 正式推出音频处理领域的重磅突破——SAM Audio。这是全球首个统一的多模态音频分离模型,它能让用户像“用眼睛听声音”一样,从一段混杂的视频或音频中一键提取出任意目标声音。这项技术首次将人类自然感知声音的方式——看、说、指、选,完整复刻到了 AI 系统中。

SAM Audio 的核心是其自研的感知编码器视听(PE-AV),被 Meta 称为模型的“耳朵”。该引擎首次将高级视觉理解能力与音频信号深度融合,实现了跨模态的声音定位与分离。

三种直觉化交互方式

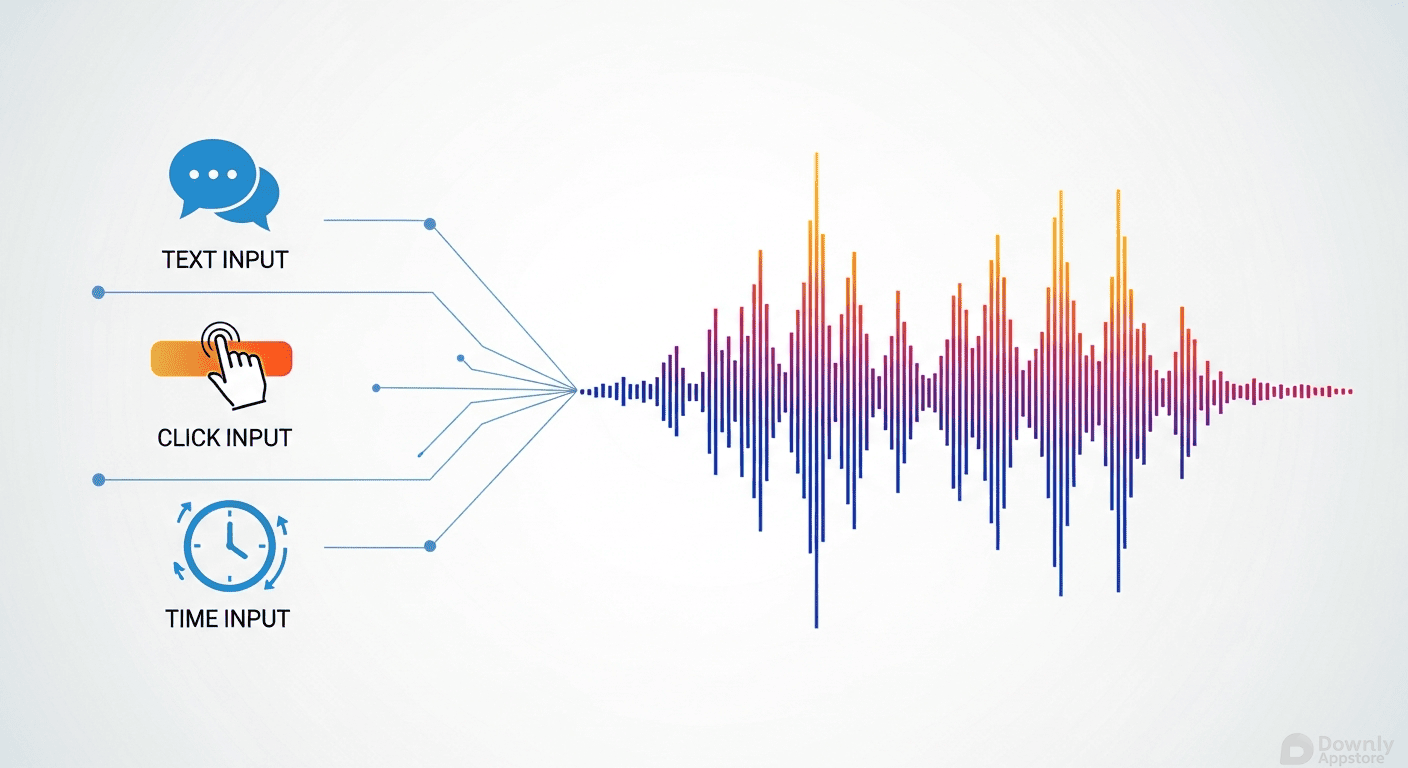

SAM Audio 支持三种直觉化交互方式,可单独或组合使用

- 文本提示 输入“人声演唱”、“汽车喇叭”等语义描述,自动提取对应声源。

- 视觉提示 在视频画面中点击发声物体(如说话的人、敲鼓的手),系统即分离其音频。

- 时间片段提示 行业首创功能,通过标记目标声音出现的时间区间,模型自动处理整段录音中的同类声音。

推动音频技术标准化

为推动技术发展,Meta 同步开源了两大关键工具

- SAM Audio-Bench 首个基于真实场景的音频分离评测基准。

- SAM Audio Judge 全球首个专用于音频分离质量的自动评估模型。

重塑感官体验的新起点

PE-AV 引擎不仅是 SAM Audio 的底层核心,未来还将赋能 Meta 的字幕生成、视频理解与智能剪辑系统。它的开源意味着开发者可构建从自动消噪会议记录到沉浸式 AR 音频交互的各种应用。在视频内容爆炸式增长的今天,SAM Audio 的出现标志着音频处理正式进入“可交互、可编辑、可理解”的新时代。

相关推荐

2025 AI 技术峰会

AI 实战课程

热门工具

AI 助手

智能对话,提升效率

智能图像处理

一键美化,智能修图

AI 翻译

多语言实时翻译

评论 (0)

暂无评论,快来发表第一条评论吧!